2014-05-16[n年前へ]

■見る方向で姿が変わるリアルな浮世絵を3次元的にグリグリ眺めてみよう!?

幕末から明治にかけての浮世絵師「月岡芳年」の作品を3次元的に眺めてみよう!? で月岡芳年の浮世絵の見え方を復元してみましたが、その復元結果を、Three.jsで色々眺めることができるようにしておきました。ポインタ操作やキー操作(Contrlなど)を使い、眺める位置を変えつつ眺めると、見る方向で姿が変わるリアルな浮世絵の姿が浮かび上がってきて、とても面白いかもしれません。

幕末から明治にかけての浮世絵師「月岡芳年」の作品を3次元的に眺めてみよう!? で月岡芳年の浮世絵の見え方を復元してみましたが、その復元結果を、Three.jsで色々眺めることができるようにしておきました。ポインタ操作やキー操作(Contrlなど)を使い、眺める位置を変えつつ眺めると、見る方向で姿が変わるリアルな浮世絵の姿が浮かび上がってきて、とても面白いかもしれません。

参考までに、幕末から明治にかけての浮世絵師「月岡芳年」の作品を3次元的に眺めてみよう!?で行ったことをメモしておきます。物体表面の反射モデルは、その対象や近似の度合いに応じて種々あります。そのひとつ、Cook-Torrance+Lambertのモデルだと、表面各点の情報は、完全拡散の色情報を表す(たとえばRGB色空間だと)RGBの3スカラーと、表面の屈折率と表面粗さ(をある近似のもとに表すMicro facet係数)という、合計5つのスカラー量で表されます。逆に言うと、5つの未知数があります。さらには、版画に使われる材料では、その屈折率は高々1.5倍程度しか違わないので、屈折率については無視しても大差ないというわけで、未知数は高々4つになります。

参考までに、幕末から明治にかけての浮世絵師「月岡芳年」の作品を3次元的に眺めてみよう!?で行ったことをメモしておきます。物体表面の反射モデルは、その対象や近似の度合いに応じて種々あります。そのひとつ、Cook-Torrance+Lambertのモデルだと、表面各点の情報は、完全拡散の色情報を表す(たとえばRGB色空間だと)RGBの3スカラーと、表面の屈折率と表面粗さ(をある近似のもとに表すMicro facet係数)という、合計5つのスカラー量で表されます。逆に言うと、5つの未知数があります。さらには、版画に使われる材料では、その屈折率は高々1.5倍程度しか違わないので、屈折率については無視しても大差ないというわけで、未知数は高々4つになります。

そこで、ColorDesigner(分光画像による超高精細・高忠実色再現画像の紹介)のような、正面・側面からと照明方向を変えて撮影した2画像があれば、各点に対してRGB画像×2という6つの情報が得られるので、先の5つ(もしくは4つ)の未知数を求めることができる、反射モデル(に必要な係数)を求めることができる、というわけです。

複数方向から照明を行った画像や、あるいは、複数方向から撮影した画像があれば、その画像を3次元的に眺めたようすを復元することができます。

幕末から明治にかけての浮世絵師「月岡芳年」の作品を3次元的に眺めてみよう!?

2016-01-18[n年前へ]

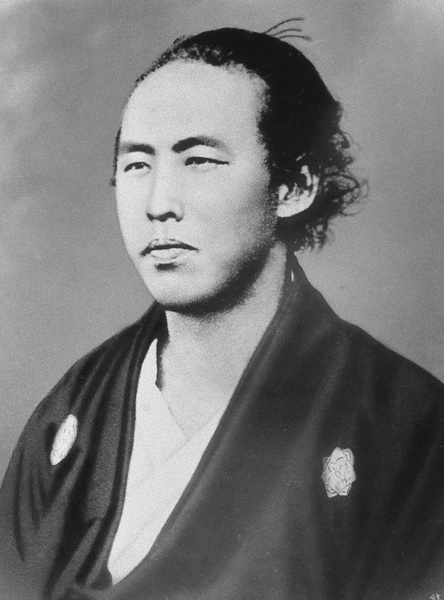

■「坂本龍馬」の白黒写真を機械学習でカラフルに眺めてみよう!?

CNN(Convolution Neural Network)機械学習による自動彩色(Google発のtensorFlowで実装した Automatic Colorization)に、約150年前に撮影された江戸時代末期の土佐藩志士「坂本龍馬」の白黒写真を入力させてみました。その結果得られた画像は、カラフルで生き生きとした…けれど少し昔の青年の顔です。(添付画像は彩度を上げたもの)

CNN(Convolution Neural Network)機械学習による自動彩色(Google発のtensorFlowで実装した Automatic Colorization)に、約150年前に撮影された江戸時代末期の土佐藩志士「坂本龍馬」の白黒写真を入力させてみました。その結果得られた画像は、カラフルで生き生きとした…けれど少し昔の青年の顔です。(添付画像は彩度を上げたもの)

色情報を全く含まないはずの白黒フィルムに焼き込まれた風景や人の姿を、今やカラフルに「それっぽく」眺めることも簡単な時代です。たとえば、歴史の教科書に載っていたような白黒写真で覚えた人たちや風景を、カラフルに眺めてみるのも面白いような気がします。

そしてまた、こうした機械学習による「自動彩色」の例を眺めていると(たとえば自動彩色した「七人の侍」など)、手作業で行う最適化の苦労なんて、もう20年近く前に終わったはずの20世紀に置いてこないとダメな過去の遺物なんだった…ということを強く意識させられます。