2010-03-21[n年前へ]

■最大200倍の拡大倍率を誇るモバイルデジタル顕微鏡『Anyty 3R-A200』でミクロな世界を覗いてみた!

「最大200倍の拡大倍率を誇るモバイルデジタル顕微鏡『Anyty 3R-A200』でミクロな世界を覗いてみた!」

「最大200倍の拡大倍率を誇るモバイルデジタル顕微鏡『Anyty 3R-A200』でミクロな世界を覗いてみた!」

外観はデジカメですが、この『Anyty 3R-A200』はモバイルデジタル顕微鏡。光学ズーム10~40倍、デジタルズーム5倍を合わせて、最大200倍の拡大倍率で画像・映像を撮影できちゃうんです。

2010-05-17[n年前へ]

■桜の写真、料理の写真…… NEC、画像に自動でタグ付けする技術

「桜の写真、料理の写真…… NEC、画像に自動でタグ付けする技術」

「桜の写真、料理の写真…… NEC、画像に自動でタグ付けする技術」

NECは、写真に写った風景や物体などの情報を解析し、内容に合ったタグを自動的に付与していく技術を開発した。ユーザーが撮影した多数の写真を手間を掛けずに分類し、後で検索しやすくする。プログラムや解析用データベースの容量が小さく、携帯電話などの小型機器に実装し、アプリ単体で動作するスタンドアローン型の処理ができる点が特徴。

類似検索用のデータベースは写真が入力されるごとにデータを追加する仕組みとなっており、写真の枚数が増えるにつれ学習度も上がり誤差を小さくできるとする。

0000-12-18[n年前へ]

■微速度動画撮影アプリケーションに思うこと

iPhoneで微速度動画撮影を作り、テスト動画を撮影した時、こんなことを感じました。何かを測るためでなく、ただ娯楽のために微速度動画を撮影するアプリケーションを作るなら「撮影する動画の速度は、対象の動き・変化に応じたもの」にしなければならないのではないか、ということです。動いて行く対象物、あるいは色合いが変化する対象物、その動き・変化に応じて動画の時間ステップを速くしたり・遅くしたりしなければならなさそうだ、と思われたのです。

iPhoneで微速度動画撮影を作り、テスト動画を撮影した時、こんなことを感じました。何かを測るためでなく、ただ娯楽のために微速度動画を撮影するアプリケーションを作るなら「撮影する動画の速度は、対象の動き・変化に応じたもの」にしなければならないのではないか、ということです。動いて行く対象物、あるいは色合いが変化する対象物、その動き・変化に応じて動画の時間ステップを速くしたり・遅くしたりしなければならなさそうだ、と思われたのです。

たとえば、雲の速度を撮影開始時に知ることは(簡単には)できません。だから、青空と雲を撮影する時に、動画撮影速度を前もって決めるということは難しいのです。それは、人や乗り物などが動いて行くようすを撮影する場合も同じです。動画撮影速度は、ただひたすらに景色を眺め続けるカメラ自身が(完成された動画を眺める人の感覚を考えながら)決めるしかない、ように思われるのです。

たとえば、雲の速度を撮影開始時に知ることは(簡単には)できません。だから、青空と雲を撮影する時に、動画撮影速度を前もって決めるということは難しいのです。それは、人や乗り物などが動いて行くようすを撮影する場合も同じです。動画撮影速度は、ただひたすらに景色を眺め続けるカメラ自身が(完成された動画を眺める人の感覚を考えながら)決めるしかない、ように思われるのです。

そしてまた、撮影動画の(時間方向の)画像スムーシングをさせようと考えた場合にも、その画像スムーシング処理は、対象物の変化に応じたスケールで行うことが必要になります。けれど、その時間方向スムーシングに関するスケールは前もって決めることはできず、対象物を眺めながら動的に決めるか、適切ではないスムーシング処理をかけるか、という2択になるように思われるのです。

ところで、iPhoneを買ったのは「自分でプログラミングすることで機能を増やすことができて、なおかつ、ネット接続ができるカメラが欲しくて」、そんな候補の中のひとつとしてiPhoneを選びました。iPhoneに限らず「こんな機能のカメラがあったら良いな」というものがあったら、教えて頂ければうれしいなと思います。それが作れるものであれば、ぜひともカタチにしてみたい、のです。

ところで、iPhoneを買ったのは「自分でプログラミングすることで機能を増やすことができて、なおかつ、ネット接続ができるカメラが欲しくて」、そんな候補の中のひとつとしてiPhoneを選びました。iPhoneに限らず「こんな機能のカメラがあったら良いな」というものがあったら、教えて頂ければうれしいなと思います。それが作れるものであれば、ぜひともカタチにしてみたい、のです。

2016-09-06[n年前へ]

■Dual Pixe Raw画像から距離(深度)マップを作成してみる!?

撮像素子の各画像素子を2分割して、その情報差を使って任意の場所でオートフォーカスしたりするための生画像データ(Dual Pixel Raw画像)を展開するソフトが公開されていました。 そのツールを使って(微小距離離れた)2視点から同時撮影された画像の情報を元に、言い換えれば2視点(AとB)に記録された光情報をAとA+Bという2形態で記録された画像データとして展開し、写された景色までの距離を各画素毎に算出した深度マップを計算してみました。といっても、やったことは単純で、2視点で撮影した画像パターンの相関をもとに三角測量的に距離を出してみたのが、下に貼り付けた画像です。

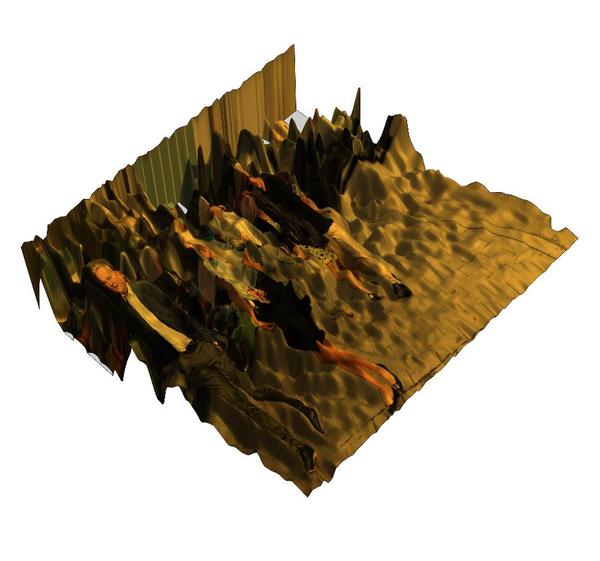

そしてまた、推定した距離画像に、RGB色画像をテクスチャマッピングして3次元的に眺めてみた例が右の画像です。近景を歩く数人と、その後ろに広がる遠景が形作る箱庭のような風景をこんな風に3次元グラフとして眺めてみるのも面白いような気がします。

そしてまた、推定した距離画像に、RGB色画像をテクスチャマッピングして3次元的に眺めてみた例が右の画像です。近景を歩く数人と、その後ろに広がる遠景が形作る箱庭のような風景をこんな風に3次元グラフとして眺めてみるのも面白いような気がします。

ちなみに、Dual Pixe Raw画像から得られた2視点画像を、「視差アニメーションGIF」的に眺めてみたアニメーションは下動画のようになります。立体感をどれだけ感じるかは微妙ですが、割と面白い結果が得られたので、ここにメモしておくことにします。

2017-01-08[n年前へ]

■ネット画像から有名人の個人情報(静脈パターン)を可視化してみよう!?

SNSなど投稿した「ピースマークなどの指写真」から指紋を推定する記事「指紋がネットで狙われている! 手の画像は悪用恐れ… 国立情報学研が新技術の実用化目指す」を読みました。写真の解像度が高ければ、指紋の抽出は確かにできそうです。もっとも、2017年時点の、よくある撮影解像度やアップロード画像解像度を考えると、指紋抽出はまだ困難な気がします。

撮影の解像度だけを考えれば、皮膚内での波長毎の吸収・散乱特性の違いによる静脈可視化の方が楽かもしれません。掌を走る静脈は、その模様が人ごとに違うため、個人認証機器に多く使われたりします。そこで、各波長(RGB画像)の特性の違いを利用して、静脈推定をしてみることにしました。

撮影の解像度だけを考えれば、皮膚内での波長毎の吸収・散乱特性の違いによる静脈可視化の方が楽かもしれません。掌を走る静脈は、その模様が人ごとに違うため、個人認証機器に多く使われたりします。そこで、各波長(RGB画像)の特性の違いを利用して、静脈推定をしてみることにしました。

まずはネット上から掌が映った写真を探してみることにします。有名人の掌が映った写真はとても多く、観客に手を振る写真・演説中に両手の掌を開いて聴衆に見せている写真など、さまざまなパターンの画像が手に入ります。

そして、静脈を可視化するために色の違いを利用するとなると、重要なことは「圧縮率が低い画像を探す」ということです。なぜかというと、人の視覚系は明度に対しては敏感ですが、色の違いに対しては解像力が低いため、多くの画像ファイルでは色情報が圧縮され低解像度になっているからです。

圧縮率が低く・掌が映った有名人画像を探してみると、まず最初に見つかったのが綾瀬はるかさんの写真です(下左図)。この画像に「静脈部分を抽出する画像処理」を掛けてみると、皮膚下を走る静脈が浮かび上がってきます(下右図)。

静脈模様を可視化する用途には、ネットにアップロードされている画像では圧縮率が問題になります。しかし、自分で撮影する画像なら、撮影さえすれば、圧縮が掛かっていない画像が手に入ります。…ということは、個人情報を狙われやすい有名人の人は、静脈模様を覆い隠す「静脈盗撮防止用のコンシーラー」などが必需品になるかもしれません。